Was manchmal von Anfang an fehlt: Auch an das Ende des Prozesses denken!

Seit ungefähr 5 Jahren beschäftigt man sich in der Branche der Technischen Kommunikation intensiver mit einer neuen Form der Informationsverteilung: Mit Content-Delivery-Anwendungen!

Delivery hat vieles verändert

Sogar ein neuer Gattungsname der Systeme hat sich dadurch ergeben: „Content Delivery Portale“ also „CDP“ als Oberbegriff für alle portalähnlichen Anwendungen, die es endlich erlauben sollen, zu leben, was man eigentlich immer schon machen wollte: Inhalte dynamischer verteilen und dies situativ angepasst für den Anwendungsfall. In diesem Fall sollen also die Nutzer wirklich nur das sehen, hören, lesen, was sie gerade wirklich brauchen.

Bereits davor gab es vieles, was als z.B. „mobile Dokumentation“ in diese Richtung ging. Aber doch mehr als Online-Hilfen und Apps ggf. mit multimedialen Inhalten. Richtig spannend wird es aber dann, wenn man nun all die vielen Dinge nutzbar macht, die man sich fleißig - manchmal ja doch über Jahre und mit mehreren Anläufen, bis es passt - in der Redaktion erarbeitet hat: Den Metadaten mit Taxonomien und Hierarchien, die bisher primär der Automatisierung der Dokumenterstellung dienten. Diese sorgen im CDP dafür, dass nun ganze andere Mechanismen für die Suche über Facetten, für die Verknüpfung von Inhalten und auch des automatisierten Aufrufs und der Anzeige möglich sind. Damit werden Inhalte eben erst in modernen Szenarien - sei es IoT, Industrie 4.0, oder wie man das auch immer als nächstes nennen mag - einsetzbar“.

Da war doch noch was?

Neben der Begeisterung für die neuen Möglichkeiten der Systeme und Prozesse wird man aber nachdenklich, wenn man erkennt, dass man mit diesen einige andere Dinge leicht vergisst. Ja, man eventuell sogar noch nie wirklich daran gedacht hat.

Wie steht es beim Aufbau der Informationslogistik mit Content und Systemen eigentlich mit der Sicherung, d.h. Speicherung der erstellten Inhalte bzw. Dokumente? Und zwar rechtssicher, auf zertifizierten und wirklich sicheren Wegen und auf sehr, sehr lange Zeit. So lange, wie es die branchenabhängigen Aufbewahrungsfristen verlangen; aber eben auch bis zu 30 Jahren darüber hinaus, wenn es eben im Deliktsfall darauf ankommt, schnell nachzuweisen, welche Dokumentation „wirklich rausging“. Und dies nachweislich und nachweislich unverändert!

Mit Redaktionssystemen managed, d.h. erstellt und verwaltet man die Inhalte. Â Nachweisbar effizient und intelligent. Aber die in diversen Medien erstellten Dokumente sind dadurch noch nicht, wie gefordert, „wirklich“ archiviert. In einzelnen Projekten gibt es Anbindungen an z.B. SAP oder andere Unternehmenssysteme. Aber nur selten werden wirklich zertifizierbare Prozesse mit sicheren Übertragungswegen und spezialisierten Langzeitarchiven als Komplett-Szenario betrachtet.

Dies sollte sich nun ändern. Systemhersteller wie SCHEMA bieten seit Kurzem Standard-Schnittstellen und die System- bzw. Prozessintegration mit entsprechenden Archiv-Systemen bzw. Konzepten an. Als Standard-Konzept könnte sich hier das SafeArch®-Konzept entwickeln: Mit diesem kann die sichere Content-Übertragung aus dem CMS prozessgesteuert mit den notwendigen Archivsystemen verknüpft und betrieben werden.

Damit wäre also gesichert, dass sich jede Publikation „die rausgeht“ auch wirklich genau so im Archiv befindet und dass alle Vorgänge dazu rechtssicher nachvollziehbar sind. Soweit also schon echter Fortschritt!

Und alles wird dynamisch

Was aber nun, wenn zukünftig immer mehr Informationen rein dynamisch „delivered“ werden? Und immer weniger statische Dokumente in PDF-Form? Auch dies wird von CMS- und CDP-Herstellern wie SCHEMA mit SafeArch® möglich gemacht werden. Die Szenarien sind dabei einfach noch eine Stufe weitergedacht:

Inhalte, die an ein CDP übertragen werden, müssen natürlich weiterhin archiviert werden; nur in anderen Formaten und Packungen als bisher. Aber genau diese „Verfügbarmachung“ wird dann auch über Konzepte wie SafeArch® nachweisbar gemacht werden müssen.

Noch einen Schritt weiter auf den Stufen der Nachweisbarkeit geht es dann, wenn nachfolgende Prozesse getrackt, d.h. verfolgt oder vom Nutzer bestätigt werden sollen. So z.B. der Zugriff oder der Download von Informationen oder Dokumenten, die ja auch weiter über ein CDP verfügbar sein können. Letzteres könnte in Zukunft sogar Teil der gegenseitigen Vertragserfüllung werden.

Auch das eigentliche Suchen, Lesen oder das eigene Zusammenstellen von Inhalten kann über Web-Methoden protokolliert werden. Archiviert werden dann immer mehr dieser Prozessdaten um nachzuweisen, was also „wirklich“ an die Nutzer ging.

Eigentlich ja auch logisch, dass mit dynamischeren Inhalten auch die Prozessdaten und dann deren Archivierung dynamisch werden müssen. Oder? So ist der Prozesse eben zu Ende gedacht.

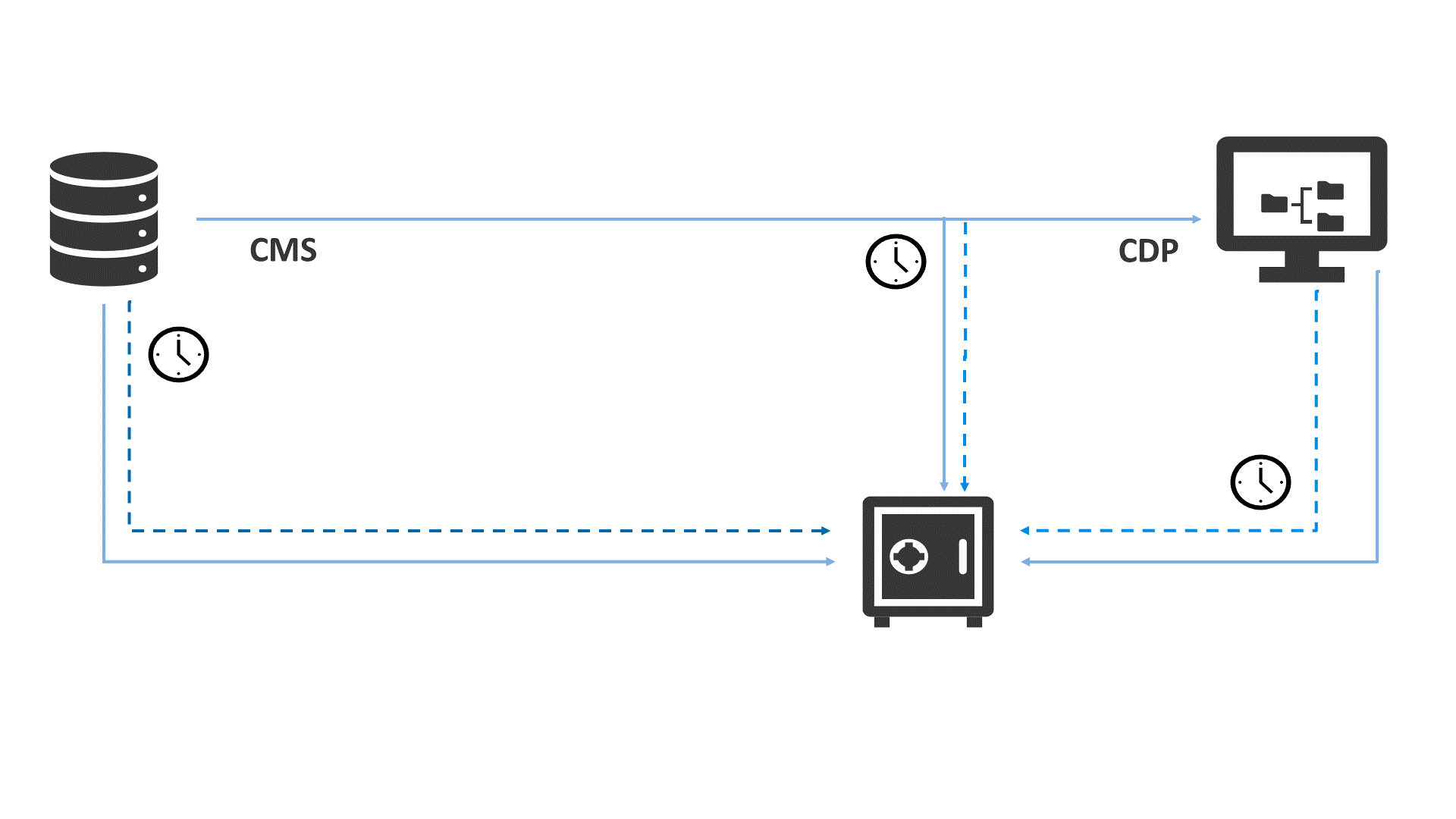

Integration von CMS, CDP nach dem SafeArch®-Prinzip: CMS-Inhalte (Linie) mit zeitabhängigen Prozessdaten (gestrichelt) werden sicher übertragen und im Archiv (unten) langzeitarchiviert. Ebenso die Verfügbarmachung von CDP-Inhalten sowie - je nach Anwendungstiefe - die Nutzung in Delivery-Systemen

Über Prof. Dr. Wolfgang Ziegler

Wolfgang Ziegler ist Theoretischer Physiker und seit 2003 an der Hochschule Karlsruhe tätig. Er forscht und lehrt auch international auf dem Gebiet des Informations- und Content-Managements. Außerdem berät er über das Institut für Informations- und Content-Management seit über 20 Jahren Unternehmen rund um die intelligente Informationslogistik. Bekannt ist er als CMS- und CDP-Experte mit Themen wie PI-Class, REx-Kennzahlen, Delivery-Konzepte wie CoReAn (CDP-Analytics) und microDocs.

Andere Artikel von Quanos

Das könnte Sie auch interessieren

Ab Oktober wird Content Delivery schneller – Mit Quanos Content Solutions

Hand aufs Herz: Delivern Sie schon? Hochschulen unterrichten darüber, bei der tekom Jahrestagung ist es regelmäßig Th…

So klappt die SCHEMA CDS-Einführung bei Caterpillar Energy Solutions

Content Delivery ist in Technischen Redaktionen ein heiß diskutiertes Thema. Über den Nutzen sind sich die meisten Re…